本篇博客小菌为大家带来的是关于Hive自定义函数的相关内容!

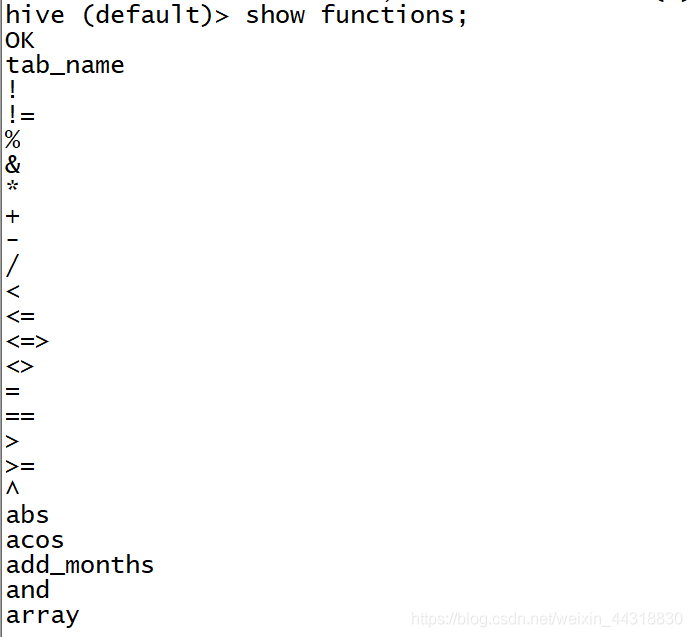

首先先让我们来看下系统自带的函数有哪些!

进入Hive,在命令行输入show functions;

发现hive自带的函数就有近一百个,但我们平时经常用到的可能就那么几个,并且自带的函数功能还十分受限!有时候,为了更好的实现业务需求,可能就需要我们去自定义Hive!

根据用户自定义函数类别分为以下三种:

(1)UDF(User-Defined-Function)

一进一出

(2)UDAF(User-Defined Aggregation Function)

聚集函数,多进一出

类似于:count/max/min

(3)UDTF(User-Defined Table-Generating Functions)

一进多出

如lateral view explore()

编程步骤:

(1)继承org.apache.hadoop.hive.ql.UDF

(2)需要实现evaluate函数;evaluate函数支持重载;

注意事项:

(1)UDF必须要有返回类型,可以返回null,但是返回类型不能为void;

(2)UDF中常用Text/LongWritable等类型,不推荐使用java类型;

简单UDF示例

第一步:创建maven java 工程,导入jar包

<repositories>

<repository>

<id>cloudera</id>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0-cdh5.14.0</version>

</dependency>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>1.1.0-cdh5.14.0</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.0</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

<encoding>UTF-8</encoding>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>2.2</version>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<filters>

<filter>

<artifact>*:*</artifact>

<excludes>

<exclude>META-INF/*.SF</exclude>

<exclude>META-INF/*.DSA</exclude>

<exclude>META-INF/*/RSA</exclude>

</excludes>

</filter>

</filters>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>第二步:开发java类继承UDF,并重载evaluate 方法

public class UDF_01 extends UDF {

//自定义函数,实现大写转换!

public Text evaluate(final Text s){

if (null == s){

return null;

}

//返回大写字母

return new Text(s.toString().toUpperCase());

}

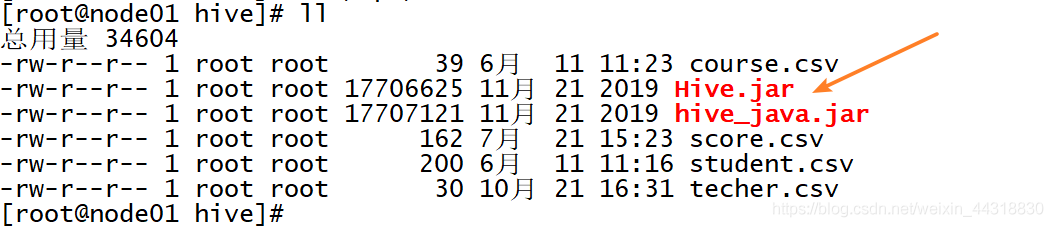

}第三步:将我们的项目打包,并上传到linux的目录下

这里我们将Hive.jar存放在了/opt/hive的目录下

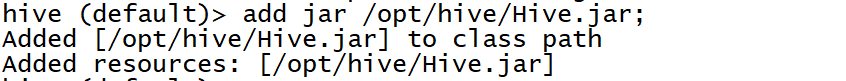

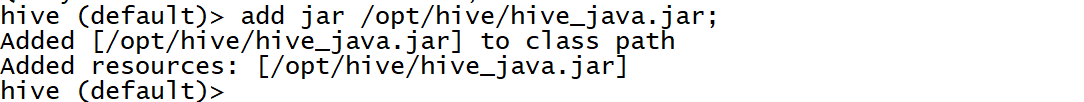

第四步:将jar包添加到hive

在hive shell 内 add jar 路径+jar包

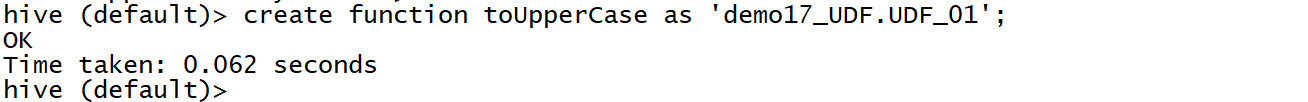

第五步:创建临时函数(永久的函数将temporary删掉)

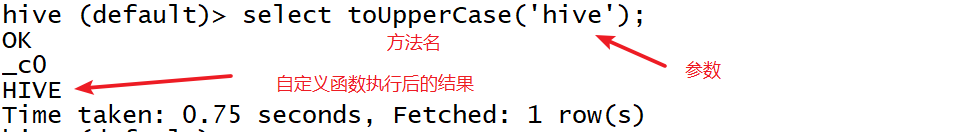

第六步:调用验证

通过reflect调用java方法

经历完了上面自定义函数过后,相信大家一定还是觉得过程有点繁琐。不用担心,接下来小菌将为大家带来如何在Hive中调用java方法。

第一步:使用java代码编写业务逻辑,并打包上传

public class JAVA_02 {

public static String addInfo(String info){

return info+"__ I love Hive! __ ";

}

}第二步:将jar包添加到hive

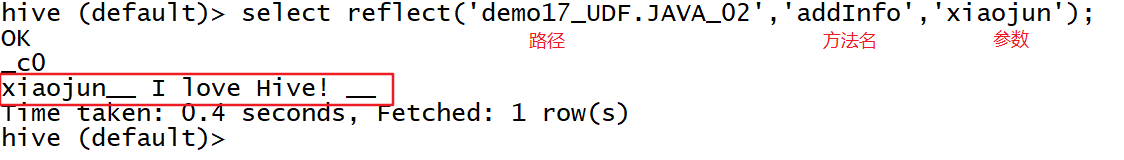

第三步:调用

select reflect (‘参数一’,‘参数二’,‘参数三’)

参数一: 包名-类名

参数二: 方法名

参数三:需要计算的数据

本次的分享就到这里了,不知道小伙伴们操作得是否顺利呢?后续小菌还会为大家带来更多Hive的精彩内容,敬请期待!!!