定位:深层学习在哪

1、深层学习需要什么?

数学

线性代数:是有关任意维度空间下事物状态和状态变化的规则。

概 率:是用来衡量我们对事物在跨时间后不同状态的确信度。

编程

操作矩阵

实现数学想法

学习的难点

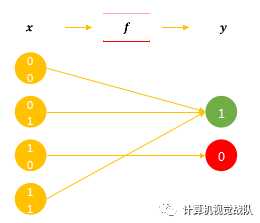

其实就是学习寻找关联函数f的过程。

难点:需要在未见过的任务上表现良好

有一种极端情况:

记忆:记住所有的高考题和对应答案。

实际:无法被穷尽,各式各样的变体。

关于函数f的寻找

维度的问题:

维度越大,我们越无法获得所有的情况。

面临没见过的情况,一般是将左右的情况平均一下。但是这种方法在高维数据下并不适用。

分布式表达:

原本需要8个不同情况,现在只需要6个。因为8个变体是又3种因素组合而成的。

数字表示法:解决变化的因素。

椭圆这个factor实际上也是有变体的,可以以相同的思路继续拆分,继续降低训练所需数据量。

深层VS浅层

分布式表达是将变体拆分成因素。但是如果用无限节点的浅层网络,所拆分的变体并不会在不同样本之间形成共享。

而深层神经网络,由于拆分的变体可以在不同样本间共享,在浅层网络中只负责学习自己的关联,而在深层网络中,那些共用相同因素的样本也会被间接的训练到。换句话说,深层的优势在于节省了训练所需的数据量。

关键:因素的共享

深层神经网络

学习的过程是因素间的关系的拆分,关系的拆分是信息的回卷,信息的回卷是变体的消除,变体的消除是不确定性的缩减。

自然界两个固有的先验知识:

并行:新状态是由若干旧状态并行组合形成。

迭代:新状态由已形成的状态再次迭代形成。

一些技术

多任务学习muti-task learning,利用的是因素共享,多个任务共享相同的知识,这样就会更容易确定我们真正想要的关联f,而排除掉那些只符合训练数据集,而不符合测试数据集的关联。

joint learning,end-to-end learning,是因素共享+因素拆分的联合应用。

通过缩减人工预处理和后续处理,尽可能使模型从原始输入到最终输出,给模型更多可以根据数据自动调节的空间,增加模型的整体契合度。

人工智能对我们的影响