文章目录

- 2023

- Scaling-up Remote Sensing Segmentation Dataset with Segment Anything Model

- Personalize Segment Anything Model with One Shot

- Segment Anything in Medical Images

- Matcher: Segment Anything with One Shot Using All-Purpose Feature Matching

- Customized Segment Anything Model for Medical Image Segmentation

- CAN SAM COUNT ANYTHING? AN EMPIRICAL STUDY ON SAM COUNTING

- SAD: Segment Any RGBD

2023

Scaling-up Remote Sensing Segmentation Dataset with Segment Anything Model

code: https://paperswithcode.com/paper/scaling-up-remote-sensing-segmentation

摘要: 分段任意事物模型(SAM)的成功证明了以数据为中心的机器学习的重要性。然而,由于标注遥感(RS)图像的困难和高成本,大量有价值的RS数据仍未被标记,特别是在像素级。在本研究中,我们利用SAM和现有的RS目标检测数据集,开发了一个有效的管道来生成一个大规模的RS分割数据集,称为SAMRS。SAMRS在大小上比现有的高分辨率RS分割数据集多出几个数量级,并提供了对象类别、位置和实例信息,可以用于语义分割、实例分割和对象检测,可以单独或组合。我们还从各个方面对SAMRS进行了全面的分析。我们希望它能促进RS分割的研究,特别是在大型模型的预训练中。

Personalize Segment Anything Model with One Shot

code: https://paperswithcode.com/paper/personalize-segment-anything-model-with-one

摘要: 在大数据预训练的驱动下,分段任何模型(SAM)已经被证明是一个强大和可提示的框架,彻底改变了分割模型。尽管具有普遍性,但在没有人工提示的情况下为特定的视觉概念定制SAM还没有被探索过,例如,自动将你的宠物狗分割成不同的图像。在本文中,我们提出了一种无训练的SAM个性化方法,称为PerSAM。只给定一个带有参考掩模的图像,PerSAM首先通过位置先验定位目标概念,并通过三种技术将其分割到其他图像或视频中:目标引导注意、目标语义提示和级联后细化。通过这种方式,我们有效地使SAM适应私人使用。为了进一步缓解掩模的模糊性,我们提出了一种有效的一次性微调变体,PerSAM-F。为了冻结整个SAM,我们为多尺度掩模引入了两个可学习的权值,在10秒内只训练2个参数以提高性能。为了证明我们的有效性,我们构建了一个新的分割数据集,PerSeg,用于个性化评估,并测试了我们的方法在视频对象分割具有竞争力的性能。此外,我们的方法还可以增强梦亭,以个性化稳定扩散的文本到图像生成,从而消除背景干扰,更好地进行目标外观学习。

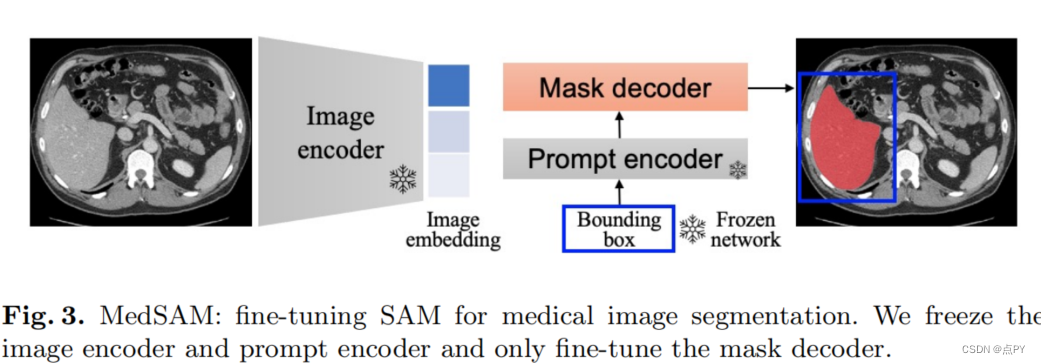

Segment Anything in Medical Images

code: https://github.com/bowang-lab/MedSAM

摘要:分割一切模型(SAM)已经彻底改变了自然图像分割,但其在医学图像上的性能是有限的。这项工作提出了MedSAM,这是第一次尝试将SAM的成功扩展到医学图像,其目标是创建一个通用的工具,用于分割各种医疗目标。具体来说,我们首先策划了一个大规模的医学图像数据集,包括跨越11种不同模式的超过20万掩膜。然后,我们开发了一种简单的微调方法,使SAM适应于一般的医学图像分割。对21个3D分割任务和9个2D分割任务的综合实验表明,MedSAM在3D和2D分割任务上的平均骰子相似系数(DSC)分别为22.5%和17.6%。

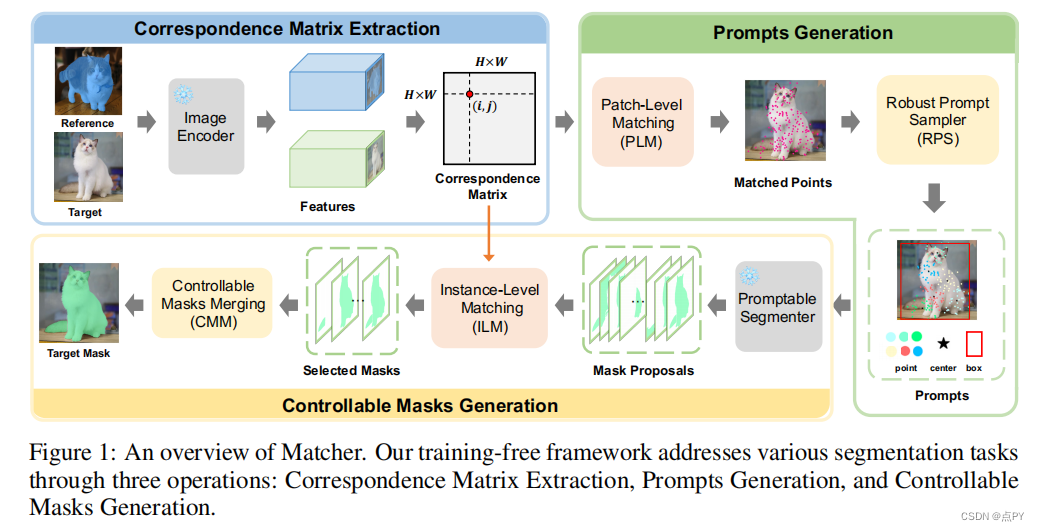

Matcher: Segment Anything with One Shot Using All-Purpose Feature Matching

code: https://github.com/aim-uofa/Matcher

摘要:在大规模的预训练支持下,视觉基础模型在开放世界图像理解方面显示出巨大的潜力。尽管单个模型的能力有限,但正确地结合多个这样的模型可以产生积极的协同效应,并发挥其全部潜力。在这项工作中,我们提出了匹配器,它通过集成一个通用的特征提取模型和一个类不可知的分割模型来分割任何东西。天真地连接模型会导致不令人满意的性能,例如,模型倾向于产生匹配的异常值和假阳性的掩模片段。为了解决这些问题,我们设计了一种双向匹配策略,用于精确的交叉图像语义密集匹配,以及一个鲁棒的提示采样器,用于掩模建议的生成。此外,我们提出了一种新的实例级匹配策略。所提出的匹配器方法在各种分割任务中提供了令人印象深刻的泛化性能,所有这些都没有经过训练。例如,它在COCO-20i的一次性语义分割上实现了52.7%的mIoU,超过了目前最先进的专家模型1.6%。此外,我们的可视化结果显示了开放世界的通用性和灵活性。

Customized Segment Anything Model for Medical Image Segmentation

code: https://github.com/hitachinsk/SAMed 摘要:我们提出了一种医学图像分割的通用解决方案SAMed。与以往的方法不同,SAMed建立在大规模图像分割模型,分段任意模型(SAM)的基础上,探索定制大规模医学图像分割模型的新研究范式。SAMed将基于低秩(LoRA)的微调策略应用于SAM图像编码器,并将其与提示编码器和掩码解码器一起对已标记的医学图像分割数据集进行细化。我们还观察到预热微调策略和AdamW优化器导致SAMed成功收敛和降低损失。与SAM不同,SAMed可以对医学图像进行语义分割。我们训练的SAMed模型在突触多器官分割数据集上达到了81.88 DSC和20.64 HD,这与最先进的方法相当。我们进行了大量的实验来验证我们的设计的有效性。由于SAMed只更新了SAM参数的一小部分,因此它的部署成本和存储成本在实际使用中相当边际。

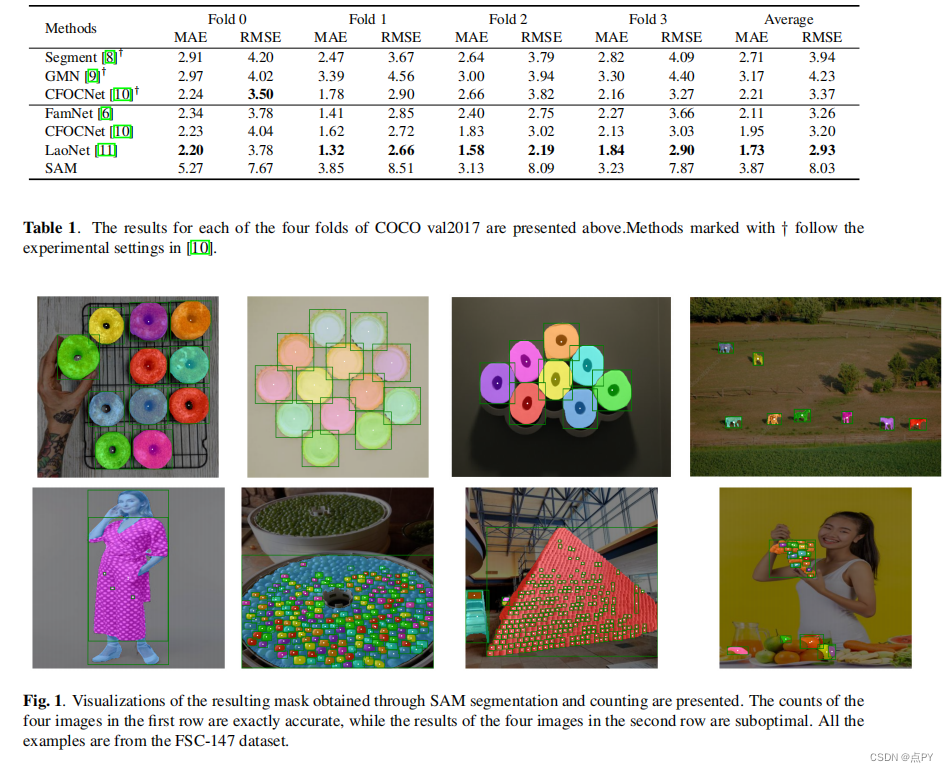

CAN SAM COUNT ANYTHING? AN EMPIRICAL STUDY ON SAM COUNTING

code: https://github.com/vision-intelligence-and-robots-group/count-anything

摘要:Meta AI最近发布了“分段任何东西模型”(SAM),该模型因其在类不可知分割方面令人印象深刻的表现而获得了关注。在本研究中,我们探讨了使用SAM进行具有挑战性的少镜头对象计数任务,即通过提供几个边界框来计数一个看不见类别的对象。我们将SAM的性能与其他少量的镜头计数方法进行了比较,发现目前没有进一步的微调,它并不令人满意,特别是对于小的和拥挤的对象。

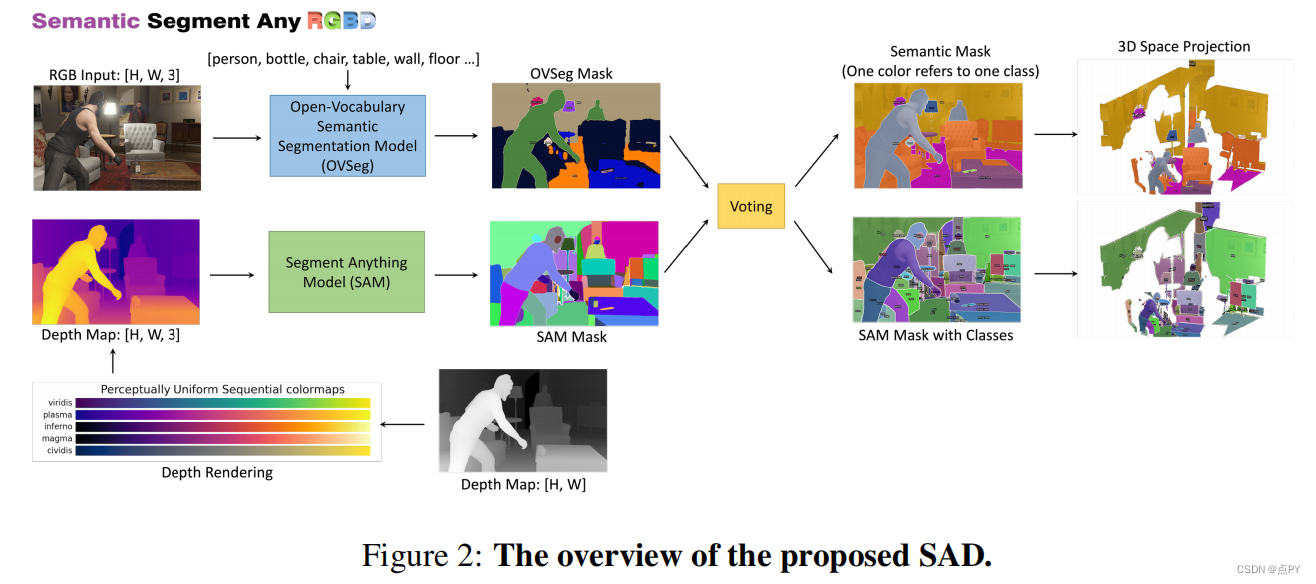

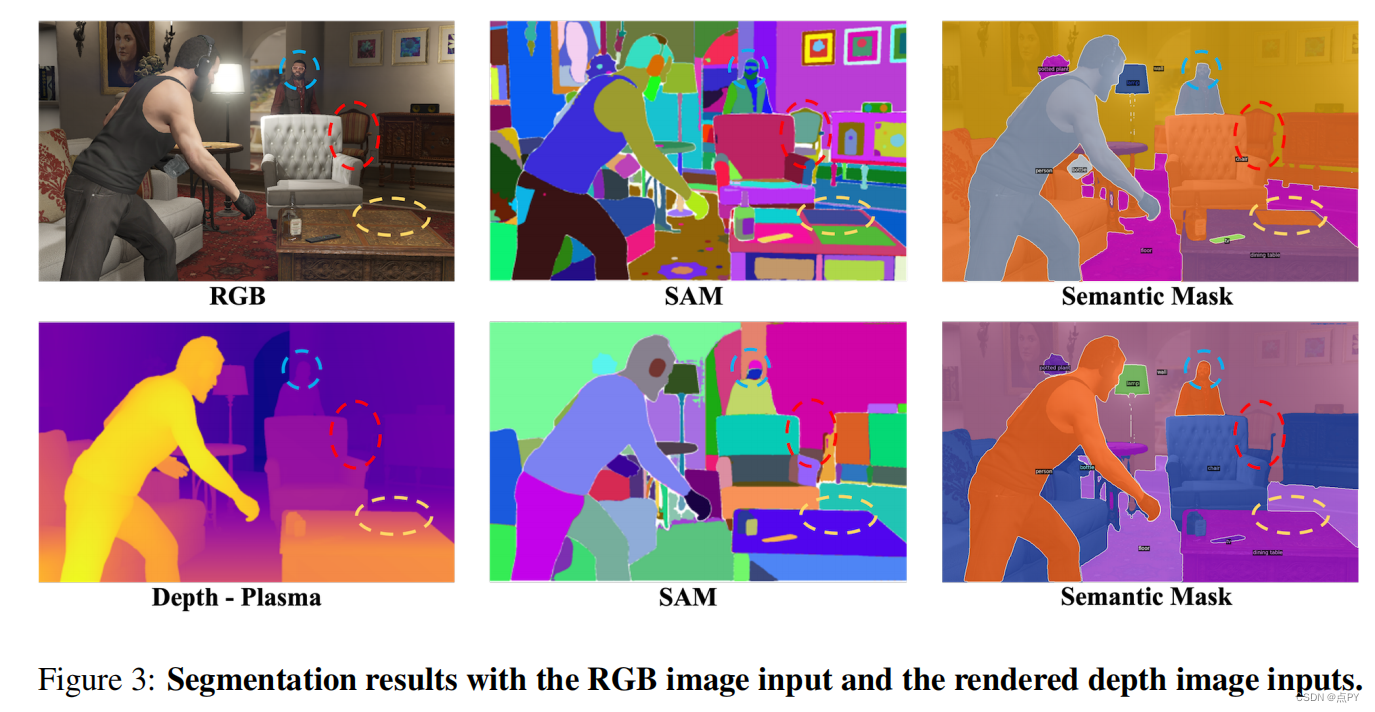

SAD: Segment Any RGBD

code: https://github.com/jun-cen/segmentanyrgbd 摘要: 分段任意模型(SAM)已经证明了它在分割2D RGB图像的任何部分方面的有效性。然而,在分割RGB图像时,SAM更重视纹理信息,而对几何信息的重视较少。为了解决这一限制,我们提出了分段Any RGBD(SAD)模型,它是专门设计用于直接从图像中提取几何信息的。受到人类通过深度地图的可视化来识别物体的自然能力的启发,SAD利用SAM对渲染的深度地图进行分割,从而提供了增强的几何信息的线索,并减轻了过度分割的问题。我们在我们的框架中进一步包含了开放词汇表的语义分割,从而实现了三维的全视分割。