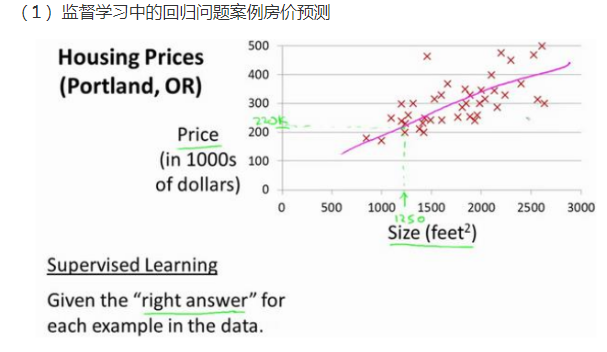

Q1模型表示

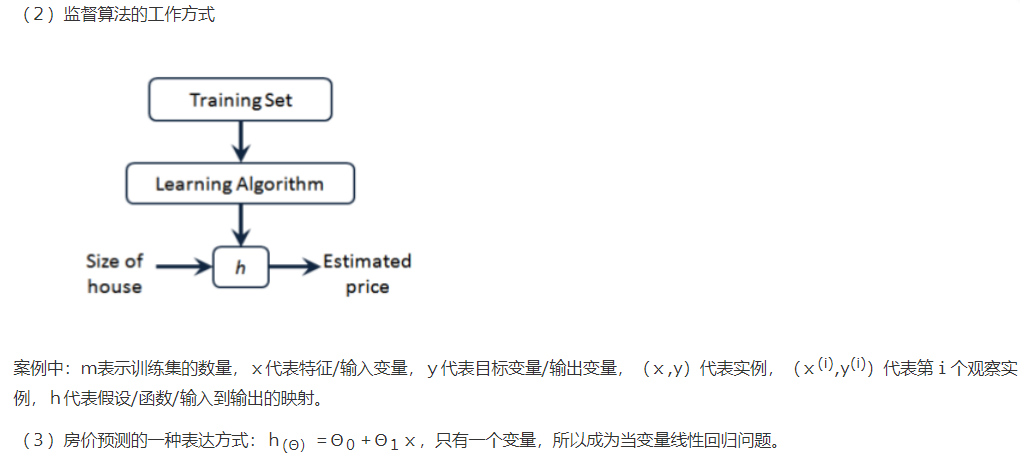

Q2:代价函数

对于回归问题常用的代价函数是平方误差代价函数:

我们的目标选取合适的参数Θ使得误差函数最小,即直线最逼近真实情况。

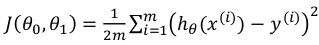

Q3:代价函数的直观理解(一个参数)

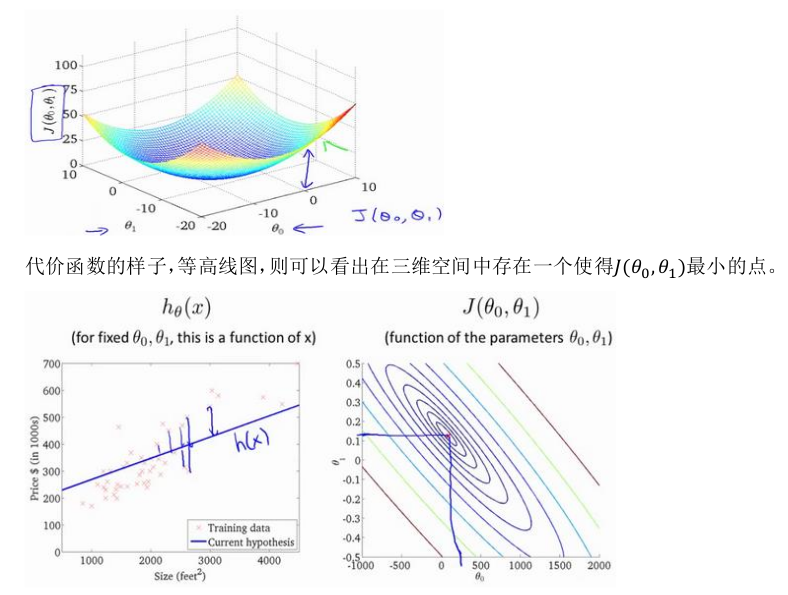

Q4:代价函数的直观理解(两个参数)

Q5梯度下降

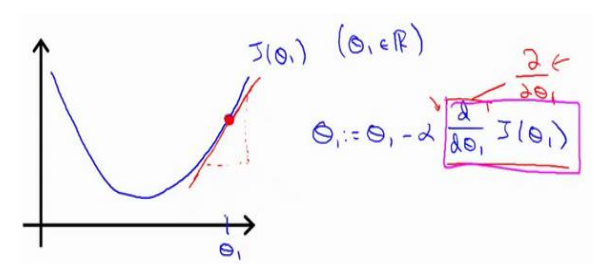

Q6梯度下降的直观理解

(1)梯度下降法可以最小化任何代价函数,而不仅仅局限于线性回归中的代价函数。

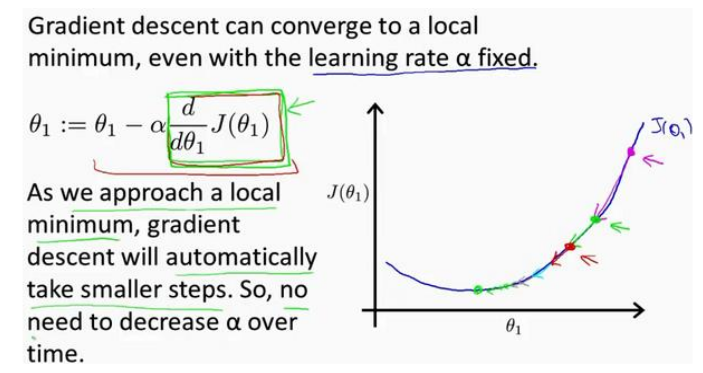

(2)当越来越靠近局部最小值时,梯度值会变小,所以即使学习率不变,参数变化的幅度也会随之减小。

(3)学习率过小时参数变化慢,到达最优点的时间长,学习率大时,可能导致代价函数无法收敛,甚至发散。

(4)梯度就是某一点的斜率。

Q7梯度下降的线性回归

英语词汇

Linear regression with one variable ---单变量线性回归

model representation ---模型表示

training set ---训练集

hypothesis ---假设

gradient descent ---梯度下降

convergence ---收敛

local minimum ---局部最小值

global minimum ---全局最大值

作者:你的雷哥

本文版权归作者所有,欢迎转载,但未经作者同意必须在文章页面给出原文连接,否则保留追究法律责任的权利。