Step_4:HIVE安装

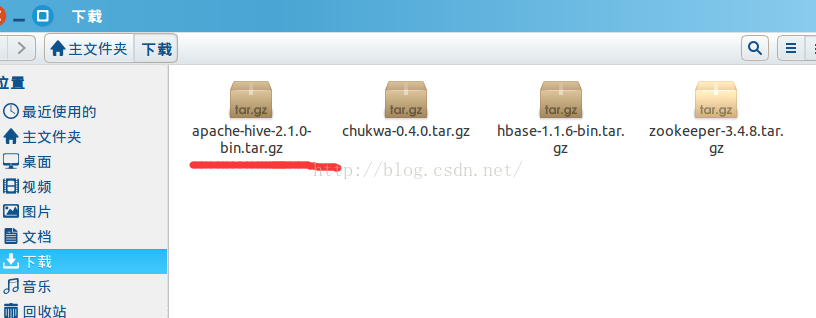

Step_4.1:下载Hive

通过:http://apache.petsads.us/hive/hive-2.1.0/,链接下载。记录下载的路径/下载,进入到下载路径下,下载成功会发现:apache-hive-2.1.0-bin.tar.gz

Step_4.2:解压并验证Hive压缩问价

进入到hive所在路径,执行:tarzxvf apache-hive-2.1.0-bin.tar.gz,然后执行:ls,查看问价是否解压成功:

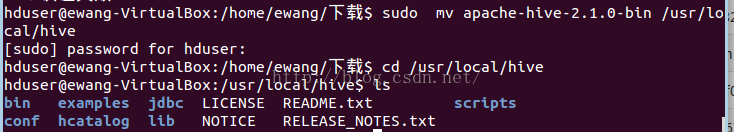

Step_4.3:把文件复制到/usr/local/hive路径下

在复制文件时由于权限不够,需要超级管理员权限。然后执行复制命令,把文件复制过去:

sudo mv apache-hive-0.14.0-bin/usr/local/hive

Step_4.4:设置Hive环境变量

在~/.bashrc文件设置Hive环境变量:

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin

export CLASSPATH=$CLASSPATH:/usr/local/hadoop/lib/*:.

export CLASSPATH=$CLASSPATH:/usr/local/hive/lib/*:.<span style="font-family: Arial, Helvetica, sans-serif; background-color: rgb(255, 255, 255);"> </span>然后执行:source ~/.bashrc

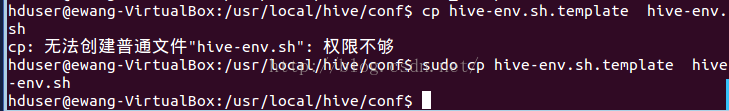

Step_5:配置Hive

为Hadoop配置Hive,需要编辑hive-env.sh文件,替换$HIVE_HOME/conf路径。执行命令重定向到Hiveconfig文件夹,并复制模板文件:

编辑hive-env.sh文件,并在文件中追加命令:

export HADOOP_HOME=/usr/local/hadoopHive安装成功后,需要一个外部数据库服务来配置Metastore。外部服务选择Apache Derby。

Step_6:下载并安装Apache Derby

Step_6.1:下载Apache Derby

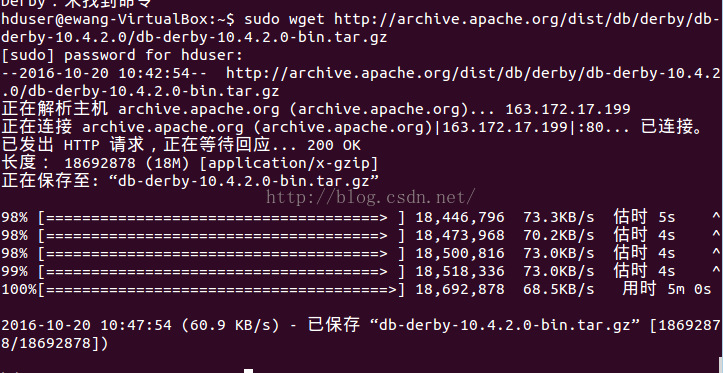

使用命令下载Apache Derby:

wget http://archive.apache.org/dist/db/derby/db-derby-10.4.2.0/db-derby-10.4.2.0-bin.tar.gz

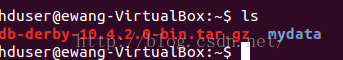

下载完成,执行:ls,查看下载文件:

Step_6.2:解压Derby文件并验证解压

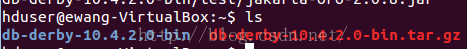

进入到下载路径下,执行命令:tar zxvf db-derby-10.4.2.0-bin.tar.gz,解压文件,然后执行:ls,查看解压是否成功:

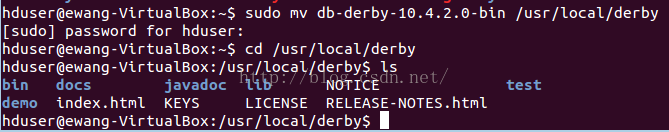

Step_6.3:把文件复制到/usr/local/derby路径下

在复制文件时由于权限不够,需要超级管理员权限。然后执行复制命令,把文件复制过去:sudo mv db-derby-10.4.2.0-bin/usr/local/derby

Step_6.4:设置Derby的环境

在~/.bashrc文件设置Derby环境变量:

export DERBY_HOME=/usr/local/derby

export PATH=$PATH:$DERBY_HOME/bin

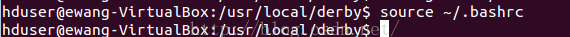

export CLASSPATH=$CLASSPATH:$DERBY_HOME/lib/derby.jar:$DERBY_HOME/lib/derbytools.jar然后执行:source ~/.bashrc

Step_6.5:创建存储Metastore的路径

在$DERBY_HOME路径下创建一个命名为data的文件夹来存储Metastore数据,执行命令:mkdir $DERBY_HOME/data

到现在为止,Derby的安装和系统设置完成!

Step_7:配置Hive的Metastore

配置Metastore意味着指定Hive存储数据库的位置。通过编辑$HIVE_HOME/conf中的hive-site.xml文件。首先,进入到路径下,执行:sudo cp hive-default.xml.template hive-site.xml

打开hive-site.xml文件,在<configuration>与 </configuration>之间添加如下属性:

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:derby://localhost:1527/metastore_db;create=true </value>

<description>JDBC connect string for a JDBC metastore </description>

</property>创建一个名为:jpox.properites的文件,并把以下内容添加进去:

javax.jdo.PersistenceManagerFactoryClass = org.jpox.PersistenceManagerFactoryImpl

org.jpox.autoCreateSchema = false

org.jpox.validateTables = false

org.jpox.validateColumns = false

org.jpox.validateConstraints = false

org.jpox.storeManagerType = rdbms

org.jpox.autoCreateSchema = true

org.jpox.autoStartMechanismMode = checked

org.jpox.transactionIsolation = read_committed

javax.jdo.option.DetachAllOnCommit = true

javax.jdo.option.NontransactionalRead = true

javax.jdo.option.ConnectionDriverName = org.apache.derby.jdbc.ClientDriver

javax.jdo.option.ConnectionURL = jdbc:derby://hadoop1:1527/metastore_db;create = true

javax.jdo.option.ConnectionUserName = APP

javax.jdo.option.ConnectionPassword = mine

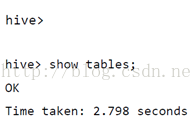

Step_8:验证Hive安装

在运行Hive之前,需要创建一个/tmp文件夹,同时在HDFS中分离Hive文件。这里,使用/user/hive/warehouse文件夹。需要给新建的文件夹赋予写的权限:chmod g+w

在验证Hive之前,需要设置在HDFS中的文件。执行命令如下:

$ $HADOOP_HOME/bin/hadoop fs -mkdir /tmp

$ $HADOOP_HOME/bin/hadoop fs -mkdir /user/hive/warehouse

$ $HADOOP_HOME/bin/hadoop fs -chmod g+w /tmp

$ $HADOOP_HOME/bin/hadoop fs -chmod g+w /user/hive/warehouse执行下面命令,验证Hive安装:

cd $HIVE_HOME/bin

./hive安装成功,响应显示如下: