1、安装scrapy相关组件

pip install scrapy -i https://pypi.tuna.tsinghua.edu.cn/simple如果在windows系统下,提示这个错误ModuleNotFoundError: No module named 'win32api',那么使用以下命令可以解决:pip install pypiwin32。

2、创建scrapy项目

必须使用命令行来创建,因为pycharm默认无法创建scrapy项目;

scrapy startproject [项目名称]示例如下:

(yunweijia) PS C:\Users\22768\yunweijia\Scripts\scrapy> scrapy startproject mode_1

New Scrapy project 'mode_1', using template directory 'C:\Users\22768\yunweijia\lib\site-packages\scrapy\templates\project', created in:

C:\Users\22768\yunweijia\Scripts\scrapy\mode_1

You can start your first spider with:

cd mode_1

scrapy genspider example example.com

(yunweijia) PS C:\Users\22768\yunweijia\Scripts\scrapy>3、创建一个爬虫

命令:

scrapy genspider 爬虫名 域名示例如下:

(yunweijia) PS C:\Users\22768\yunweijia\Scripts\scrapy\mode_1> scrapy genspider example example.com

Created spider 'example' using template 'basic' in module:

mode_1.spiders.example

(yunweijia) PS C:\Users\22768\yunweijia\Scripts\scrapy\mode_1>4、查看创建结果

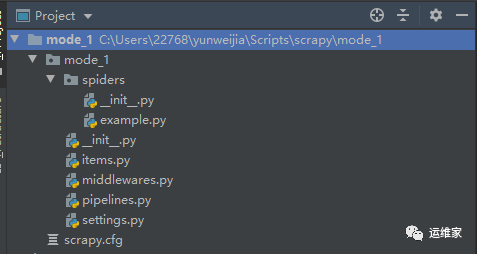

创建完毕之后可以看下具体创建了什么文件;

我们使用pycharm打开看下;

scrapy爬虫项目中每个文件的作用如下:

-

items.py:用来存放爬虫爬取下来数据的模型; -

middlewares.py:用来存放各种中间件的文件; -

pipelines.py:用来将items的模型,存储到本地磁盘中; -

settings.py:一些配置信息,比如请求头,地址代理等; -

scrapy.cfg:项目的配置文件; -

spiders:项目的爬虫都在这个目录下,可以看到我们刚创建的example这爬虫,就在这个目录下了;

更多内容请转至VX公众号 “运维家” ,获取最新文章。

------ “运维家” ------

------ “运维家” ------

------ “运维家” ------

linux系统下,mknodlinux,linux目录写权限,大白菜能安装linux吗,linux系统创建文件的方法,领克linux系统怎么装软件,linux文本定位;

ocr识别linux,linux锚定词尾,linux系统使用记录,u盘有linux镜像文件,应届生不会Linux,linux内核64位,linux自启动管理服务;

linux计算文件夹大小,linux设备名称有哪些,linux能用的虚拟机吗,linux系统进入不了命令行,如何创建kalilinux,linux跟so文件一样吗。